Software Steckbrief | Testüberblick | Kurzfassung| Testablauf / Kommentare | Screenshots | Firmenwerbung | Links

Software Steckbrief

| Nummer | S08-03 |

| Produkt | PlagiarismFinder |

| Hersteller | Mediaphor Software Entertainment AD, Detmolder Str. 164, 33100 Paderborn Wird auch vertrieben vom Beratungs- und Entwicklungsgesellschaft Context mbH |

| Web-Site | http://www.plagiarism-finder.de bzw. http://www.plagiarismfinder.de/ |

| Software-Typ | Programm für Windows, auch auf USB-Stick beziehbar für den mobilen Einsatz |

| Kosteninfo |

|

| Testdatum | 03.09.2008 |

2009-03-10: Der Hersteller kündigt Version 2.0 an

Testüberblick

Grundtests

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 | 29 | 30 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 0 | 3 | 3 | 1 | 2 | 3 | 3 | 0 | 0 | 1 | 3 | 0 | 0 | 0 | 0 | 2 | 0 | 0 | 0 | 0 | 2 | 0 | 0 | 0 | 1 | 0 | 1 | 0 | 0 | 2 |

Bewertung: 5 korrekt / 4 fast / 5 halb / 17 falsch = (3:2:1:0)

28 / 80 Punkte

Platz: 15

Usability:

| Kategorie | Kommentar | 0 – 3 |

|---|---|---|

| Website + Kostentransparenz |

|

1 |

| Layout und Beschriftungen |

|

1 |

| Navigation |

|

1 |

| Erklärungen in den Berichten |

|

0 |

| Einpassung im Workflow |

|

1 |

| Summe | 4 | |

| Note | 4,7 | |

Platz 13

Kurzfassung

Platz 15 belegte mit 28 Punkten das einst gute System, Plagiarism-Finder. Die Herstellerfirma hat 2007 abgelehnt, ihre neue Version von uns testen zu lassen. WIr haben sie angeschrieben und gebeten, das neue System nun testen zu dürfen, bekamen jedoch keine Antwort. Die Homepage hat ja auch „News“ von 2004 auf der ersten Seite. Da jedoch viele kleine Zeitungen in der letzte Zeit über das System als sehr effektiv berichten, wollten wir es unbedingt testen. Ein Vertriebspartner hat uns dann eine Vollversion angeboten. Geliefert wurde die Version 1.2, die wir 2004 getestet hatten! Es wurde aber nach der Installation angeboten, ein Update auf 1.3 vorzunehmen, was wir auch taten. Unsere Registrierung schlug fehl, was eigentlich notwendig gewesen wäre, um an die Berichte innerhalb des Systems zu kommen. Aber da die Berichte unverschlüsselt auf der Festplatte lagen, waren wir dazu in der Lage sie dennoch zu bewerten. Die Anfertigung der Berichte war schon anstrengend, da immer nach 3-5 Tests “ ist kein gültiger Integerwert “ in einem Popup erschien und das System einfror. Nur ein Neustart erlaubte die nächsten 3-5 Tests zu machen. Bei Testwiederholungen – die zunächst unbeabsichtigterweise gemacht wurden – kamen interssanterweise verschiedene Ergebnisse heraus. Eine Mitarbeiterin der Universität Marburg hat uns während des Tests kontaktiert und fragte, ob wir ihr helfen könnten. Sie hatte auch bei diesem System die nicht-deterministischen Ergebnisse beobachtet und dachte, sie würde das System falsch bedienen. Daraufhin haben wir mehrere Versuche unternommen und mussten in der Tat feststellen – auch Tests, die innerhalb von 10 Minuten wiederholt wurden, schwanken zwischen 43% und 80% Plagiat (bei einem Text, der ein Komplettplagiat ist!). Wir haben zwar die ersten Ergebnisse, die wir bekommen haben, jeweils bewertet, aber so ein System ist nicht für den Einsatz tauglich.

Testablauf/Kommentare

- Wir erhielten die Version 1.2, aber ein Update auf 1.3 wird sofort angeboten. Obwohl die Aktivierung scheitert, funktioniert etwas, die Reports werden unverschlüsselt als HTML auf der Festplatte gespeichert und können ausserhalb des Systems angesehen werden

- Eine Sortierung nach Dateityp geht nicht

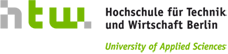

- Nach 3 -5 Tests bricht das System immer wieder mit (‚“ ist kein gültige Integerwert‘) zusammen. Ein

Neustart des Programms ist dann nötig, das ist auf Dauer sehr nervig. (siehe Screenshot 1 ) - Das Englisch ist sehr gewöhnungsbedürftig

- Auf Grund der schlechten Ergebnisse probierten wir verschiedene Einstellungen, dabei stellt sich heraus, dass man bei gleichen Einstellungen und gleichen Texten verschiedenen Ergebnisse erhält. Das bedeutet, dass PlagiarismFinder nicht deterministisch ist, und damit unbrauchbar für diesen Zweck ist.

- Wir entschieden uns vorerst den Test abzubrechen. Später setzten wir den Test fort mit den jeweiligen Default-Einstellungen.

- Das System nutzt Excite als Suchmaschine, wählt dabei aber sehr ungünstige Wörter. Wenn man selbst Wörter geschickter aus dem Text mit Excite sucht, findet man auch Quellen.

- Häufig sind Übereinstimmungen in Prozent angegeben, aber es gibt keine Quellen!

- Es werden nur ca 13 % vom Text zum Vergleich genommen.

- Jeder zweite Link ist nicht richtig, da der Suchtext vom vorherigen genommen wird (Links sind falsch hinterlegt), von diesen Links liefern nur wenige Ergebnisse, die man dann selber mit excite überprüfen muss. Da kann man auch selbst die Wörter nehmen und in Google oder Excite eingeben.

Einzeltests

- 05: zu wenige Übereinstimmung (%), daher wird 1

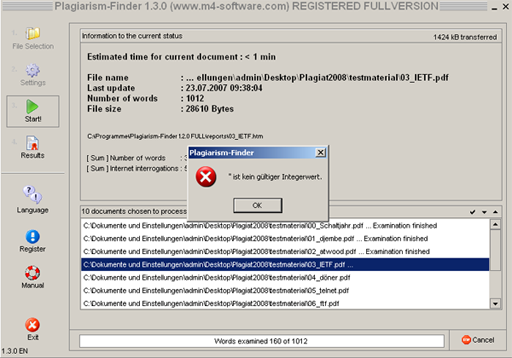

Punkt abgezogen - 08: es wird einen Übereinstimmung von 50% angegeben, aber keine Quellen, daher gibt es keine Punkte (siehe Screenshot 2 )

- 16: 43%, aber für was? nur nach mehrfachem Probieren bekommen wir eine Quellenangabe => -1 Punkte

- 17: SquareDance: mal 10% mal 14% mal 17% und für was?

- 18: für was 42%?

- 21: Computerwoche, Sueddeutsch, manche Links haben nichts gefunden

- 25: nur Wikipedia-Kopien mit weniger als 20 %

- 26: 6 % wovon, excite findet nichts

- 27: nur ein Direktlink zur Wikipedia

Sonderfälle

- 25e: Der Trick mit dem anderen ASCII -Zeichen bringt das Programm völlig durcheinander

- Sonderfall Collusion: keiner der 8 Collusiontestfälle wurde als Collusion gemeldet.

Screenshots

Screenshot 2: 50 Prozent für Nichts

Firmenwerbung

„Plagiarism-Finder ist eine Windows-Software, die sich auf jedem PC mit Internet-Anschluß installieren lässt. Sie wählen die zu überprüfenden Dokumente aus und erhalten das Ergebnis der Überprüfung nach einigen Minuten. Anschließend wissen Sie genau, welche Teile der Arbeit aus dem Internet stammen. “

Links

offizielle Website http://www.plagiarism-finder.de