oftware Steckbrief | Testüberblick | Kurzfassung| Testablauf / Kommentare | Screenshots | Firmenwerbung | Links

Software Steckbrief

| Nummer | S08-01a |

| Produkt | turnitin |

| Hersteller | iParadigms, LLC, 1624 Franklin St., 7th floor, Oakland, CA 94612, USA Europäische Reseller: nLearning, 6-8 Charlotte Square, Newcastle, NE1 4XF |

| Web-Site | http://turnitin.com bzw www.nlearning.co.uk |

| Software-Typ | Online, es ist auch integrierbar mit Blackboard und Moodle |

| Kosteninfo | Es gibt viele Lizenztypen, unter anderem Campus-Lizenzen, Fachbereichs-Lizenzen, Dozenten-Lizenzen. Der Preis hängt von der Anzahl der Studierenden ab. Man wendet sich an die Firma für mehr Information. |

| Testdatum | 02.09.2008 – 03.09.2008 und 25.09.2008 |

Testüberblick

Grundtests

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 | 29 | 30 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 2 | 0 | 2 | 3 | 3 | 1 | 1 | 2 | 2 | 3 | 1 | 3 | 0 | 0 | 3 | 0 | 2 | 3 | 3 | 1 | 1 | 1 | 0 | 0 | 2 | 1 | 0 | 1 | 1 | 0 | 3 |

Bewertung: 8 korrekt / 6 fast / 9 halb / 8 falsch = (3:2:1:0)

45 / 80 Punkte

Platz: 13

Usability:

| Kategorie | Kommentar | 0 – 3 |

|---|---|---|

| Website + Kostentransparenz |

|

2 |

| Layout und Beschriftungen |

|

1.5 |

| Navigation |

|

1,5 |

| Erklärungen in den Berichten |

|

1 |

| Einpassung im Workflow |

|

3 |

| Summe | 9 | |

| Note | 3,0 | |

Platz 6

Kurzfassung

Platz 13 mit 45 Punkten ist das sich selbst als Marktführer bezeichnende System TurnItIn. Die Usability des Systems wurde mit 3,0 im Mittelfeld gesetzt, weil die Anmeldeprozedur und das Abbilden von Kurse und Assignments – Aufgaben, die eigentlich in einem Lernmanagementsystem stattfinden sollten – kompliziert sind. Das liegt sicherlich an die Komplexität des Systems. Studentennamen mussten immer eingegeben werden und konnten im nachhinein nicht korrigiert werden. Die 6+ Navigationsleisten, teilweise mit identischen Beschriftungen die zu verschiedenen Ziele führten („Instructor“, „Accounts“) waren verwirrend.

Auch gibt es keine Kostentransparenz auf der Seite, eine Lizenz ist immer individuell zu verhandeln.

Das System hat immerhin als einer der wenigen auch Kollusion erkennen können, aber in den Berichten waren die Kollusionen teilweise nicht wegklickbar, um an die darunterliegenden Quellen zu kommen. Die ersten 20 Testfälle waren in der TurnItIn Datenbank bereits gespeichert. Sie waren nicht von uns, sondern von eine Firma, die wir 2007 bei der Verwendung von TurnItIn als eigene Suchdienst erwischt haben (siehe „Eine kuriose Geschichte„) Die Bewertung des Plagiatsgrades war suspekt – in der Regel wurden die Prozentsätze der gefundenen Quellen einfach addiert. Aber gefunden hat das System nicht viel. Das kann daran liegen, dass das System auf den anglo-amerikanischer Markt ausgerichtet ist und mit Umlauten, wie sie in deutschen Texten vorkommen, nicht adequat umgehen kann.

Wenn es uns gelang, die überdeckenden Arbeiten auszuschliessen, stellten wir erneut fest, dass die WIkipedia selten als Quelle gefunden wurde.

Auch Amazon fehlte in der Liste und manche der gemeldete „Quellen“ führten zu Web-Fehler (Fehler 404, komplett falsche Seiten (Spam) oder Zeitüberschreitung). Vermutlich waren die Seiten nicht mehr online. Das System ist nach wie vor empfindlich für die unzähligen Spam-Seiten, die erstmal ausgeschlossen werden müssen, in der Hoffnung, etwas zu finden.

Bei FTF mussten 22 Spamseiten (die oft nicht mal den Text der Wikipedia

enthielten) ausgeschlossen werden, bis die Wikipedia erschien. Umlaute haben, wie immer, Probleme bereitet, aber dazu später mehr.

Das war im ganzen ein recht anstrengender Prozess. Weil TurnItIn doch recht verbreitet ist, haben wir den Test am Ende des Testzeitraums erneut durchgeführt, um auszuschliessen dass wir Bewertungsfehler gemacht haben. Wir haben im ersten Durchgang nur 43 Punkten vergeben, haben also als Testergebnis den leicht höheren Wert des zweiten Durchgangs verwendet.

Testablauf/Kommentare

- Keine Kostentransparenz, nur ein Kontaktformular

- Die Anmeldeprozedur ist recht kompliziert (Instructor anlegen, Kurse anlegen, Assignments anlegen, aussuchen, wo die Dokumente angelegt werden sollen, Studenten anlegen)

- Die erste Seite ist ein Flash-Film

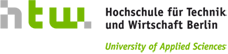

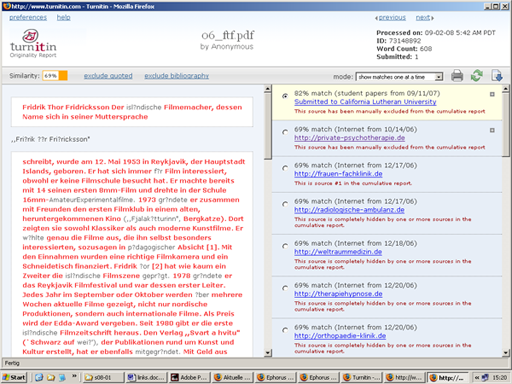

- Es gibt verwirrende Beschriftungen und doppelte Bezeichnungen. Zum Beispiel sind zwei Knöpfe mit „Instructor“ versehen, zwei mit „accounts“ – jeder leitet zu verschiedenen Ziele. (siehe Screenshot 1 )

- Korrekturen von Studentennamen können nicht vom Dozenten vorgenommen werden

- Der Zurück-Knopf im Broswer funktioniert nicht

- Es gibt 6+ Navigationsbereiche – eine verwirrende Anzahl

- Beim Test von „Exclude bibliography“ ist die von uns angegebene Bibliografie nicht ausgeschlossen worden, vielleicht ein Formatproblem?

- Die Kollusionen sind nicht wegklickbar, obwohl es dafür einen Knopf gibt.

- Die Umlaute in der Darstellung sind schlecht lesbar

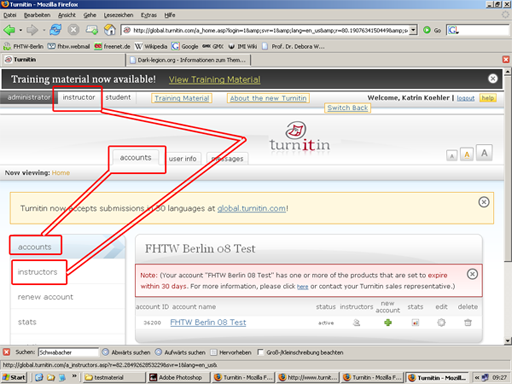

- Es passieren sehr viele Zeitüberschreitungen (siehe Screenshot 2 ) , es gibt 404er (Datei nicht gefunden) und Warnungen für angebliche Quellen der Fundstellen

- Es ist möglich, einen Klassensatz von Aufsätzen mit einem ZIP-File hochzuladen

- Nur ein Dokument pro Student ist möglich

- Man muss alle Studenten vorher eintragen, dann jedem Studenten sein Dokument zuordnen. Das ist schwierig bei einem großen ZIP-File oder bei 200 Studenten pro Lehrer

- Sehr schön: das Produkt Grademark, d.h. die Lehrkraft kann die Dokumente online korrigieren und kommentieren

- Umlaute gehen nicht, Quellen nicht gefunden

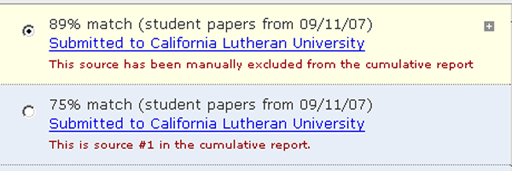

- Die alten Testfälle wurden von einer anderen Universität (California) eingereicht. Nach Rücksprache mit der Firma sind das Überreste von dem iPlagiarismCheck-Skandal beim Test 2007. Diese „Quellen“ müssen eigenständig herausgenommen werden. Es ist zwar möglich, E-Mails (requests) an den Dozenten zu schicken, was wir auch getan haben, aber wir haben keine Antwort erhalten. (siehe Screenshot 3 )

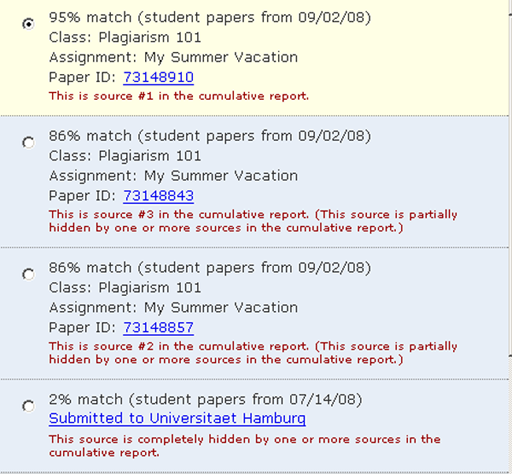

- Die Prozentzahlen von gefundenen Plagait werden anscheinend immer addiert

- Wikipedia wird immer noch zu selten gefunden

- sehr viel Spamseiten tauchen als Quelle auf (siehe Screenshot 4 )

- Turnitin ist nicht nur ein Plagiatserkennungssystem, sondern entwickelt sich zu einem Lernmanagementsystem. Es sind viele Interaktionen möglich, und viele gute Ideen integriert.

- Wir haben die Vermutung, dass die Datenbank keine neueren Einträge aus Deutschland hat, denn neuere Quellen werden nicht gefunden.

Einzeltests

- 0: nur Datumsangabe gefunden

- 02: nicht mal Amazon

- 04:

- Übereinstimmung mit sich selbst (Dokument doppelt da) , kann nicht entfernt werden -1Punkte

- ein Link geht nicht

- Verlinkung auf Startseite

- Wikipedia nicht gefunden

- 05: 5 von 5 Quellen gehen nicht (4x 404er + 1x notResponding), Quellen können nicht überprüft werden = 0 Punkte

- 06:

- 1 Quelle Zeitüberschreitung

- sehr viel Spam (private-psychotherapie und nach dessen Ausschluss Frauen-Fachklinik)

- man muss 22 mal ausschließen, bis Wikipedia gefunden wird = 0 Punkte

- 07: eine Kopie von Wikipedia aber nicht Wikipedia

- 08:

- 74 % Pharmalieferung, Zeitüberschreitung + 8 % Wikipedia

- Nimmt man dann die 9 Spams (nicht mal zu öffnen) raus hat Wikipedia plötzlich 81 %

- 09: findet die Teile des PDF´s ohne Ligaturen, wird allerdings nicht markiert

- 14: 1% Golfmagazin = 3 Punkte

- 19: California 2x drin (85% + 75%) + 12 % Medienrevolution (nur Fußnoten)

- 20: alle Quellen 404er, vom 2.10.2004

- 21: Süddeutsche mit 2 % gefunden = 1Punkt

- 25: hat Collusion mit 25e erkannt, 14 % Wikipedia = 1 Punkt

- 25e: die anderen Zeichen haben das System wirklich verwirrt, Collusion erkannt

- 27: nur Wikipedia

- 28: 5 mal die Quelle gefunden aber nur mit 5%

- 29: Collusion erkannt, aber keine Quelle gefunden

- 30: Collusion erkannt, findet sehr viele Sachen, aber nur mit 4%,

Sonderfälle

- Auch für Collusion geeignet:

(siehe Screenshot 5 )- schade, bei Collusion kann man nicht die Arbeiten nebeneinander sehen

- vermerkt die Collusion nur bei neuen Texten, nicht bei den alten Berichten

- man muss explizit den älteren Bericht Refresh’en

- problematisch: wer als letztes hochlädt sieht aus als hätte er abgeschrieben – der erste hat es am Besten

- man muss erst alle Paper abwarten und dann bei allen Refresh klicken

- schwierig wenn es 2 verschiedene Instruktoren gibt, dann merkt es vielleicht nur der eine

Screenshots

Screenshot 1: Doppelte Bezeichnungen

Screenshot 2: Zeitüberschreitung

Screenshot 3: Mehrfach eingereichte Dokumente

Screenshot 5: Collusion erkannt

Firmenwerbung

„Turnitin WriteCycle’s Originality Checking allows educators to check students‘ work for improper citation or potential plagiarism by comparing it against continuously updated databases. Every Originality Report provides instructors with the opportunity to teach their students proper citation methods as well as to safeguard their students‘ academic integrity. “

Links

offizielle Website http://turnitin.com bzw. www.nlearning.co.uk